前言

LLAMA Facotry 都是很熱門的自己微調模型的框架,因為想打造自己的客服機器人,因此參考了資料,試著嘗試想拿一些開源AI模型來調整看看。

潛在的 AI 需求

- AI 能夠回覆常見客服 FAQ。

- AI 能夠推薦套裝電腦的。

- AI 能夠依據客戶預算,自己搭配電腦零組件。

事先準備

一張 Nvidia 4070 ti super 顯示卡

硬體需求

| Method | Bits | 7B | 13B | 30B | 70B | 110B | 8x7B | 8x22B |

|---|---|---|---|---|---|---|---|---|

| Full AMP | 7 | 120GB | 240GB | 600GB | 1200GB | 2000GB | 900GB | 2400GB |

| Full | 16 | 60GB | 120GB | 300GB | 600GB | 900GB | 400GB | 1200GB |

| Freeze | 16 | 20GB | 40GB | 80GB | 200GB | 360GB | 160GB | 400GB |

| LoRA/GaLore/BAdam | 16 | 16GB | 32GB | 64GB | 160GB | 240GB | 120GB | 320GB |

| QLoRA | 8 | 10GB | 20GB | 40GB | 80GB | 140GB | 60GB | 160GB |

| QLoRA | 4 | 6GB | 12GB | 24GB | 48GB | 72GB | 30GB | 96GB |

| QLoRA | 2 | 4GB | 8GB | 16GB | 24GB | 48GB | 18GB | 48GB |

需要安裝的東西

首先,要先下載安裝 Python,這邊裝相對穩定的版本 3.12

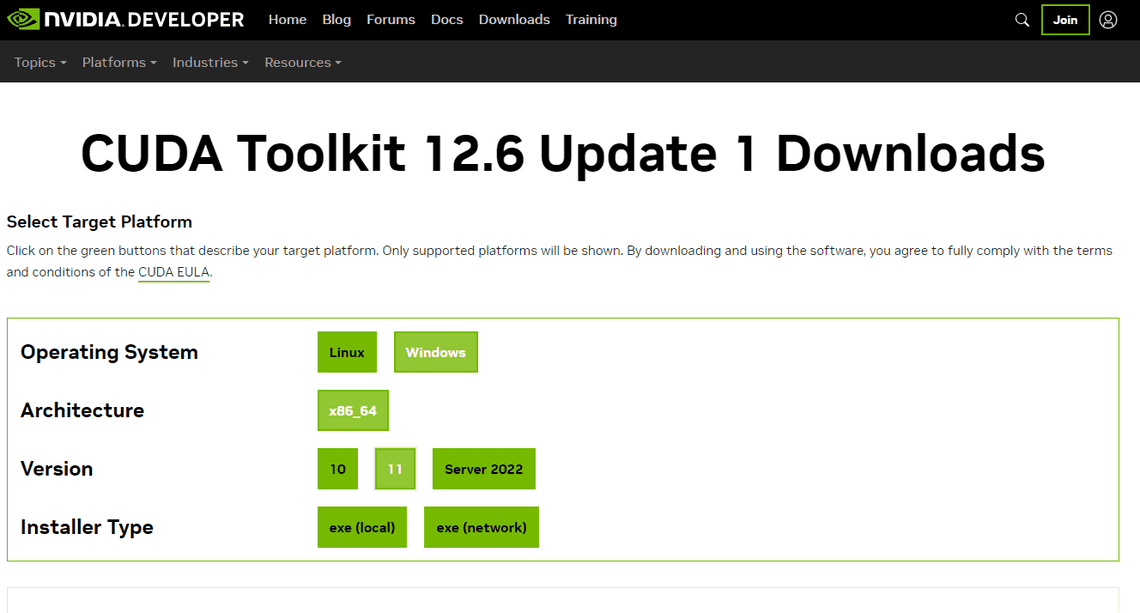

接著下載安裝 CUDA,這邊需配合顯示卡版本 (驅動程式最好一起裝)

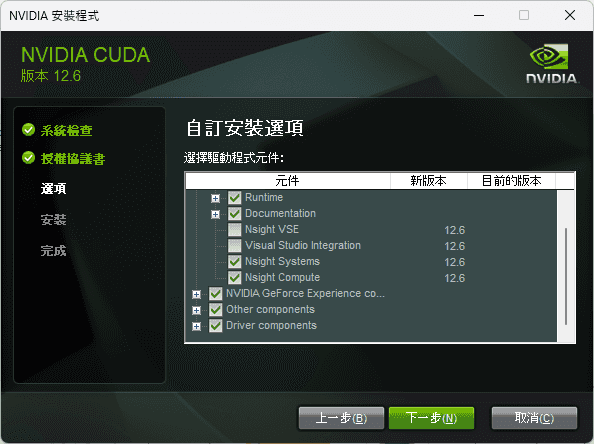

P.S. 如果在裝Drive 過程中,裝不起來,可以先將 Nsight VSE及 Visual studio Integration 先勾選掉,因為可能會因為你裝兩個版本的 Visual studio curd 會裝不起來。

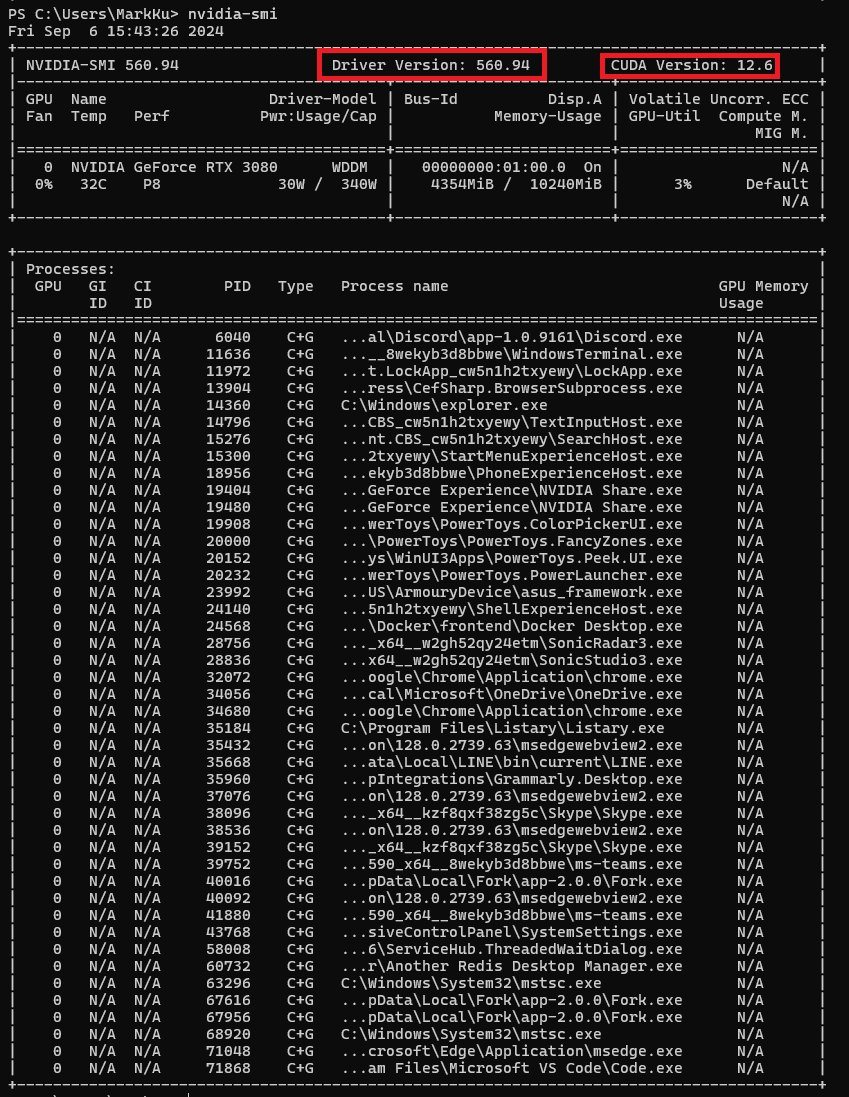

查詢驅動版本及檢查可以裝的CUDA 版本

nvidia-smi

查詢安裝的驅動及CUDA 版本

nvcc -V

再安裝 PyTorch

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu124

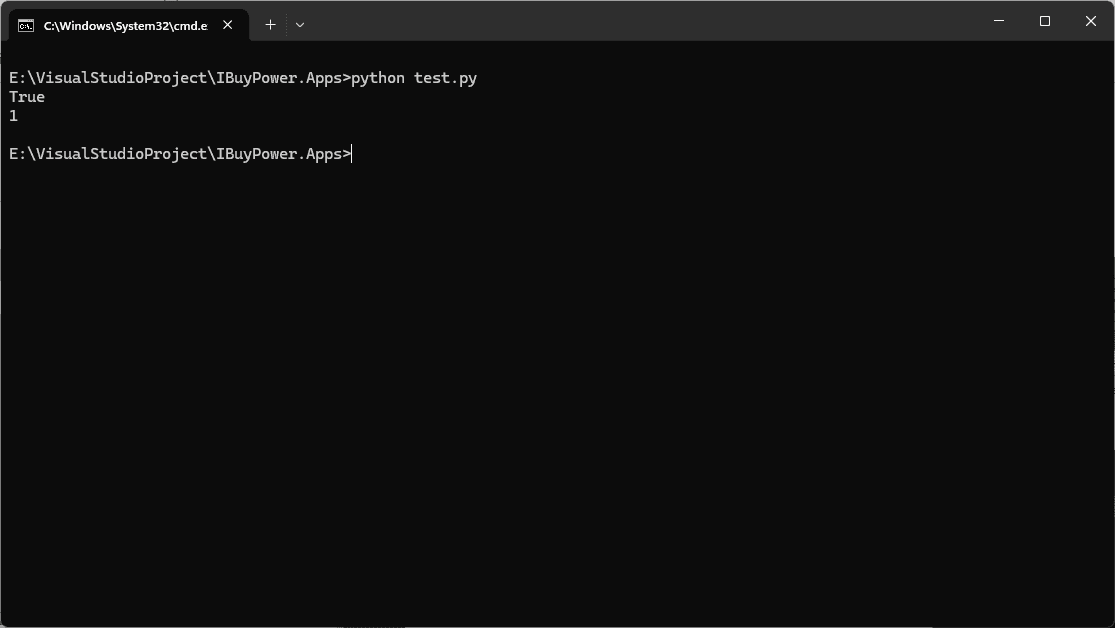

測試 Python 是不是能和 GPU 溝通 (test-gpu-test.py)

import torch print(torch.cuda.is_available()) # 是否可以用gpu False不能,True可以 print(torch.cuda.device_count()) # gpu數量, 0就是沒有,1就是檢測到了

安裝LLAMA Factory

首先,拉取程式碼

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

進入程式碼目錄

cd LLaMA-Factory

安裝依賴

pip install -e ".[torch,metrics]"

檢查是不是安裝成功

llamafactory-cli version

啟動

llamafactory-cli webui

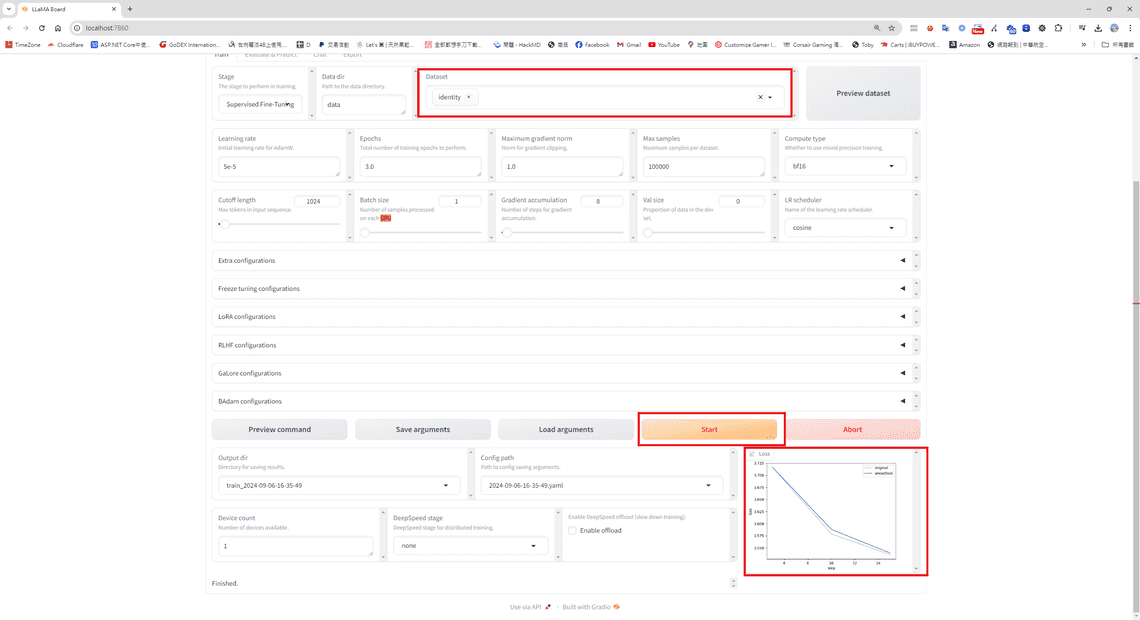

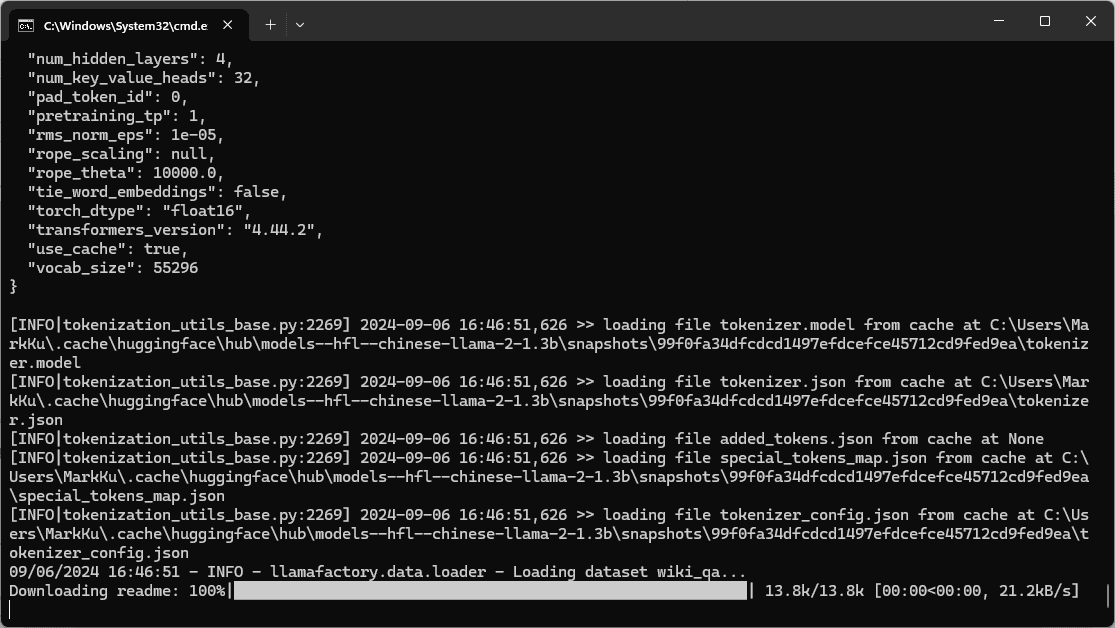

選擇資料集後,就能開始訓練模型